Algunos de los problemas de Calidad de Datos se deben a que los datos se utilizan para un fin diferente para el cual fueron diseñados.

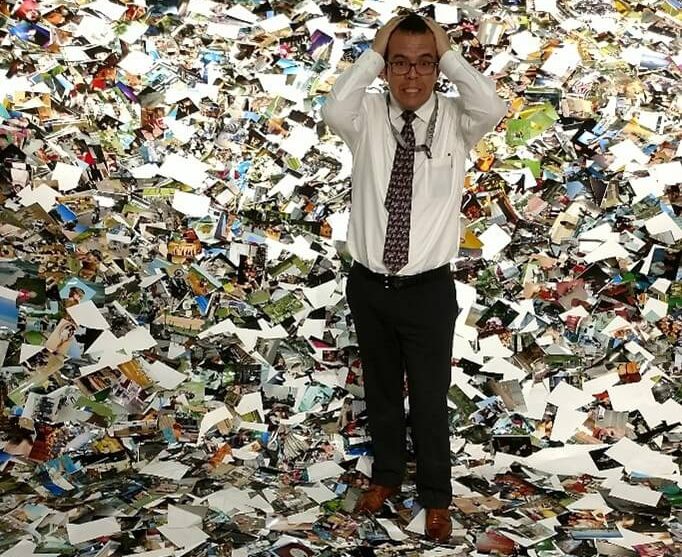

Abby Covert propone una clasificación de las causas que ocasionan que no entendamos la información:

- Información en exceso

- Información no suficiente

- Información no correcta

- Una combinación de las tres anteriores

Este artículo habla sobre la información no correcta.

La forma incorrecta de hacer frente a un problema de Calidad de Datos

Luisa una ejecutiva recién promovida de una empresa de manufactura esta por tener su primera reunión con el Consejo Directivo, cuando Pedro su asistente advierte un problema con una de las cifras que se van a presentar, lo comunica a Luisa y ella le pide investigar, después de un par de horas de investigación Pedro encuentra el error lo comunica a Luisa y actualizan la presentación, Luisa agradecida le da el resto del día libre a Pedro y comenta con él la suerte que tuvieron de haber identificado y corregido este error.

Luisa le encomienda a Pedro que cada mes vuelva a revisar las cifras para estar atentos y que ella no corra el riesgo de presentar cifras incorrectas en el Consejo Directivo, en lugar de atender la causa raíz del problema.

Consecuencias de asignar un centro geográfico arbitrario para USA

En el año 2002, derivado de un error técnico de la empresa MaxMind que cambio el centro geográfico de los 48 estados contiguos de USA, hizo que una propiedad en Potwin, Kansas, se convirtiera en la geolocalización predeterminada de 600 millones de direcciones IP (ocasionada por una falta de granularidad adecuada), si no encontraba elementos para poder ubicar por ciudad y estado dentro de USA, asignaba un valor de latitud y longitud que apuntaba al centro del país, para simplificar hizo el siguiente cambio 39.8333333, -98.585522 por un valor más fácil 38.0000 , -97.0000, de manera que si alguna de esas direcciones IP era utilizada por un estafador, un ladrón de computadoras o una persona que se comunica con una línea de ayuda, la base de datos de MaxMind las ubicaba en el mismo lugar, este error técnico fue resuelto por esta empresa y están ubicando estas direcciones predeterminadas en medio de cuerpos de agua, en lugar de propiedades de alguna persona.

Desafortunadamente actualmente hay muchas ubicaciones que sufren esta misma falla aunque en menor medida.

Imposibilidad de tomar decisiones sobre el COVID-19 en California, USA

En el estado de California, USA, a mediados del año 2020, debido al fallo de un enlace con uno de los laboratorios de pruebas más grandes del país, se estuvieron reportando menos casos de COVID-19 durante un periodo de al menos dos semanas. Los condados se vieron obligados a revisar muchas hojas de cálculo en busca de datos confiables mientras que el estado trataba entender y resolver el problema. Un total de 296,000 registros se vieron afectados.

Durante algunas semanas adicionales, se reportaron casos de semanas anteriores lo que también dificultaba la toma de decisiones relacionadas con entender las tendencias de la epidemia, si estaba creciendo o disminuyendo y con que velocidad lo estaba haciendo.

Finalmente se pusieron al corriente con la información y pudieron determinar que la tendencia iba a la baja.

¿Qué es más importante, muchos datos con baja calidad o pocos datos de buena calidad?

La respuesta es obvia, hay un mayor valor para el negocio y mayores posibilidades de utilizar un volumen relativamente reducido de datos pero de buena calidad, un estudio realizado alrededor del año 2014 en el norte de Italia deja evidencia perfectamente documentada y desarrollada.

El objetivo era determinar problemas en los medidores de agua mecánicos cuya toma de medición era realizada por personal de la compañía de agua, lo cual es un proceso caro y el poder utilizar un modelo de inteligencia artificial podría ahorrar costos importantes a la compañía, problemas como que el medidor disminuyera el consumo de un mes a otro, o que se identificaran variaciones poco razonables de un mes a otro, eran clara evidencia de que el medidor tenía alguna falla.

Los datos iniciales fueron 15 millones de lecturas de 1 millón de medidores de agua, pero identificaron dos problemas principales con los datos:

- Si la toma de alguna medición era incorrecta, el cliente iba a poner su queja en la compañía y se actualizaba la lectura en el ERP para generar la nueva factura, pero nunca se actualizaban los datos de las mediciones.

- Había muchos datos que se extrapolaban del mes anterior y con esto se facturaba al cliente, es decir, eran datos creados y no tomas de medición directas en el medidor de agua.

Después de hacer muchas de las correcciones, terminaron eliminando un gran porcentaje de los 15 millones de registros que tenían.

Conclusiones

Prácticamente todos necesitan datos de alta calidad y están conscientes de ello, pero no tienen elementos para determinar qué tan buena o mala es la información con que cuentan y el impacto que ésta tiene en su organización. Es necesario entender la situación actual e identificar los problemas relacionados con datos que se quieren resolver.

Algunos de los problemas de Calidad de Datos se deben a que la información se utiliza para un fin diferente para el cual fueron diseñados.

No existe algo como calidad de datos al 100% ya que hay muchos datos y muchas formas diferentes de usarlos, el mismo conjunto de datos una persona puede clasificarlos como con 100% de calidad y otra persona con 0% de calidad, lo cual dependerá del uso que cada una de ellas quiera darles a los datos.

Bibliografía

Covert, A. (2014). How To Make Sense of Any Mess: Information Architecture for Everybody. (N. Fenton, Ed.) Recuperado el 10 de October de 2021

Hill, K. (10 de April de 2016). How an internet mapping glitch turned a random Kansas farm into a digital hell. Recuperado el 10 de Octubre de 2021, de Splinter: https://splinternews.com/how-an-internet-mapping-glitch-turned-a-random-kansas-f-1793856052

Kelliher, F. (14 de August de 2020). With data backlog cleared, California coronavirus cases officially decreasing, Newsom says. Recuperado el 24 de Octubre de 2021, de The Mercury News: https://www.mercurynews.com/2020/08/14/with-data-backlog-cleared-coronavirus-cases-officially-decreasing-newsom-says/

Madsen, L. (2019). Disrupting Data Governance. A Call to Action. Basking Ridge, NJ, USA: Technics Publications. Recuperado el 10 de Octubre de 2021

Redman, T. C. (2016). Getting in Front on Data. Who Does What. Basking Ridge, NJ, USA: Technics Publications. Retrieved Octubre 10, 2021

Roccetti, M., Delnev, G., Casini, L., & Cappiello, G. (03 de August de 2019). Is bigger always better? A controversial journey to the center of machine learning design, with uses and misuses of big data for predicting water meter failures. Recuperado el 10 de October de 2021, de SpringerOpen: https://journalofbigdata.springeropen.com/articles/10.1186/s40537-019-0235-y